j9九游会擢升缠绵并行度;二是精确更新战略-九游娱乐(中国)有限公司-官方网站

闻乐 发自 凹非寺j9九游会

量子位 | 公众号 QbitAI

提宽绰模子挂念这块儿,好意思国大模子开源王者——英伟达也出招了。

集合Astera推敲所、斯坦福大学、UC伯克利、加州大学圣地亚哥分校等机构推出了TTT-E2E表率。

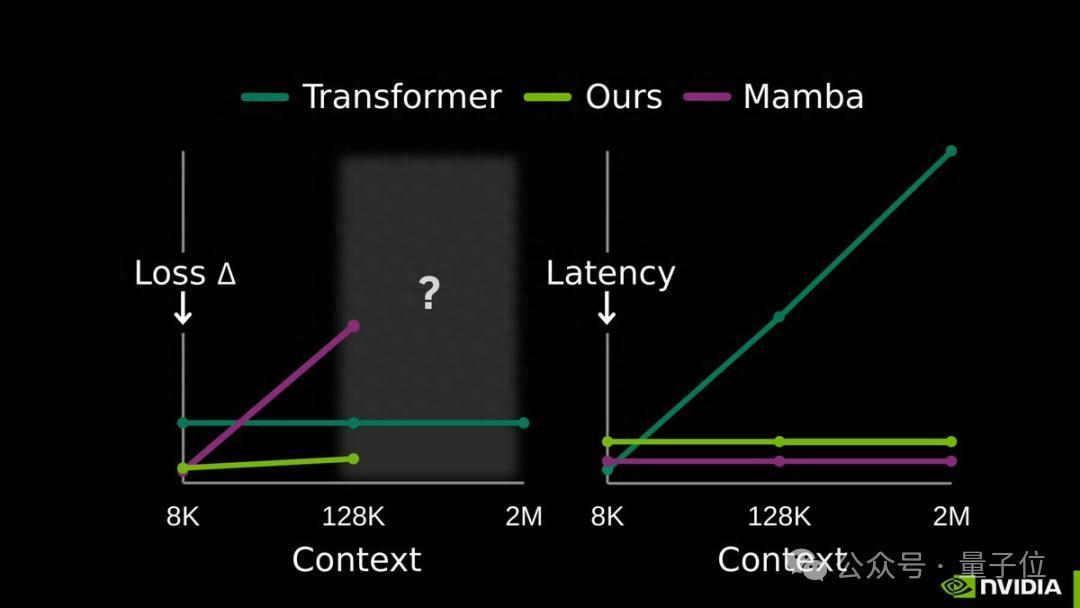

在128K超长文本上处理速率比全重见解模子快2.7倍,处理2M高下文时提速达35倍,性能还不打折。

这项时间与前几天大火的DeepSeek条目挂念模块有所不同。

DeepSeek的Engram模块依赖的是“按需查表”的静态学习旅途,而英伟达走的是动态学习的门道,要津在于高下文压缩。

通过及时学习将要津内容压缩到自己权重中,让模子在测试阶段已经保执学习景况。

这么既幸免了稀奇缓存的职守,又能精确捕捉长文本中的中枢逻辑。

给模子装上挂念压缩包

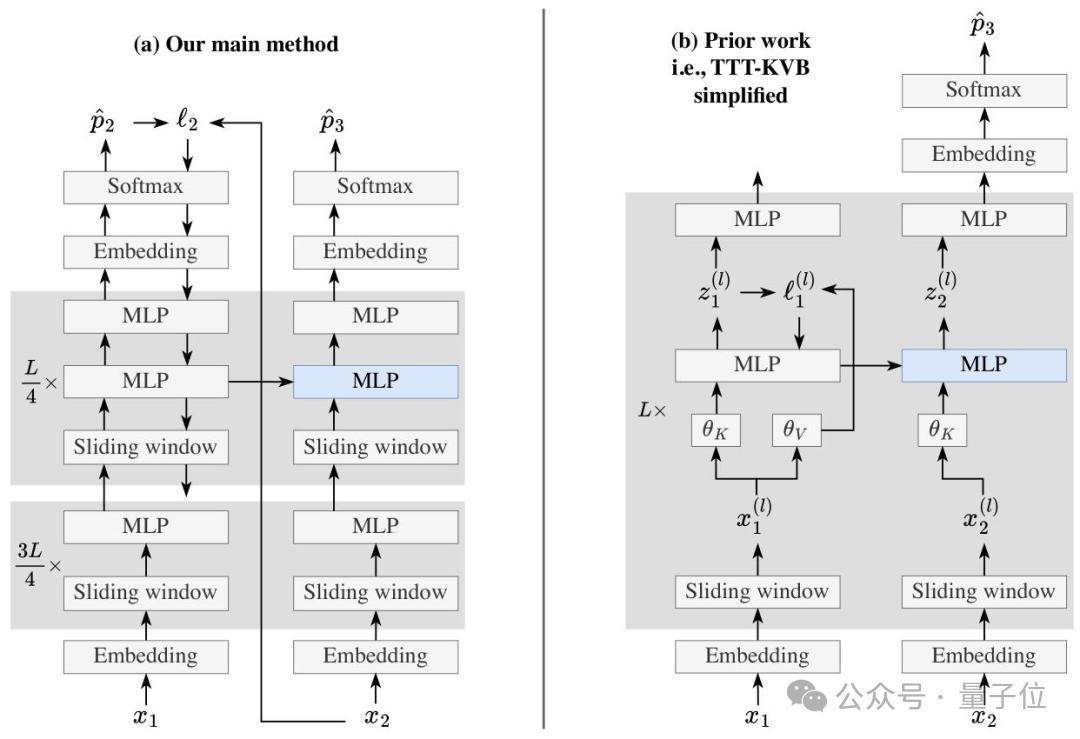

TTT-E2E并莫得依赖复杂特地架构,反而是基于带滑动窗口重见解的表率Transformer,容易部署。

这个表率的中枢念念路是将长文本建模从架构联想问题疗养为「执续学习」任务。

在测试阶段,模子会基于面前读取的高下文进行下一个词瞻望。

每读取一段文本,就通过梯度着落更新自己参数,通过这种形式执续磨练自己,把读到的文本信息动态压缩到权重中,这么就毋庸稀奇存储冗尾数据。

在磨练阶段,团队通过元学习为模子作念运行化准备,让模子天生相宜「测试时学习」的模式。

把每个磨练序列都模拟成测试序列,先在内轮回中对其进行测试时磨练,再在外轮回中优化模子的运行参数,确保运做事态就能快速适配测试时的学习需求,扫尾了磨练与测试的端到端对皆优化。

为了均衡成果与相识性,TTT-E2E还联想了三项要津优化。

一是遴荐「迷你批处理+滑动窗口」的组合战略。将测试时的磨练数据分红多个迷你批,谄谀8K大小的滑动窗口重见解,既措置了单token梯度更新易爆炸的问题,又保证模子能记着批内高下文,擢升缠绵并行度;

二是精确更新战略。只更新模子的MLP层(冻结镶嵌层、归一化层和重见解层),何况只更新终末1/4的麇集块,在减少缠绵资本的同期幸免参数更新杂沓;

三是双MLP联想。在需更新的麇集块中加入一个静态MLP层,挑升存储预磨练常识,另一个动态MLP层认真摄取新高下文,来细心模子学新忘旧。

从本质数据来看,TTT-E2E的施展很亮眼。

在3B参数模子的测试中,TTT-E2E在128K高下文长度下的测试亏蚀与全重见解Transformer执平以至更优,而Mamba 2、Gated DeltaNet等同类模子在长文本场景下性能均出现显着下滑;

在蔓延上,它的推理蔓延不随高下文长度增多而变化,与RNN近似,在H100显卡上处理128K文本时,速率比全重见解模子快2.7倍。

在解码长序列任务中,经Qwen-8B模子评估,TTT-E2E生成的文本色量相识,亏蚀值执续低于传统模子。

通过本质扫尾也不错看出,该表率的推理蔓延与高下文长度无关,长久保执恒定,这也意味着岂论处理8K照旧128K文本,用户都能赢得一致的快速反馈体验。

不外,TTT-E2E也存在一些小局限。

在大海捞针这类需要精确回忆细节的任务中,它的施展远不如全重见解模子。

这是因为它的中枢是压缩挂念,会过滤掉看似无关的细节,而全重见解模子能近乎无损地调回所有这个词信息。

另一方面,磨练阶段的元学习需要缠绵梯度的梯度,现在扫尾比表率预磨练要慢。

现在,TTT-E2E的代码和有关论文已全都开源。

这项推敲的款式总认真东说念主是斯坦福的博士后推敲员Yu Sun,他同期是该推敲的中枢孝敬者。

他推敲的总体想法是让东说念主工智能系统或者像东说念主类相同执续学习。自2019年以来,他就在建筑“测试时磨练”的想法框架,TTT-E2E款式的早期构想即是他建议的。

论文地址:https://arxiv.org/abs/2512.23675

代码地址:https://github.com/test-time-training/e2e参考流畅:https://x.com/karansdalal/status/2010774529120092481— 完 —

量子位 QbitAI · 头条号签约

关爱咱们j9九游会,第一时期获知前沿科技动态